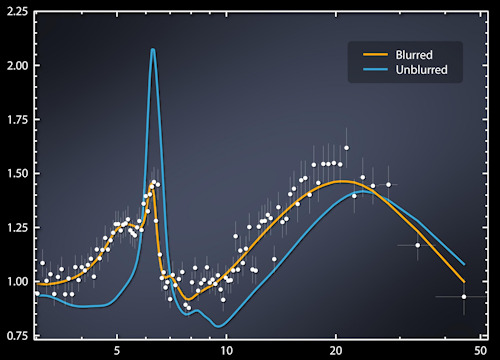

Cuando se descubrió la nueva cepa de influenza H2009N1 en el 1, se activó el procedimiento habitual de monitoreo y observación en los EE. UU., Que involucró la notificación de todos los casos a centros regionales de salud y control.

Un procedimiento capilar y de ejecución, que sin embargo tenía una limitación: describía una imagen del desarrollo del virus, siempre con dos semanas de retraso en comparación con la situación contingente.

En el mismo período, la revista. Naturaleza Publicó un artículo en el que algunos ingenieros de Google, asombrados y con incredulidad general, afirmaban poder derivar e incluso predecir la propagación geográfica de H1N1 basándose únicamente en las palabras clave utilizadas en la web.

Específicamente, a partir del 50 millones de palabras más utilizadas en la red por los usuarios de EE. UU., Los gurús de Mountain View identificaron las más utilizadas en las áreas informadas por los centros de salud regionales, y al aplicar 450 millones de modelos matemáticos diferentes pudieron destacar una correlación Palabras clave 45 y expansión de virus.

Los hechos confirmaron la noticia, y por primera vez se demostró que era posible predecir la propagación de un virus con métodos puramente matemáticos, utilizando esencialmente (enormes) cantidades de datos procesados por máquinas con capacidad informática adecuada.

Esta historia es una prueba más de cómo la revolución digital, fundada en Tecnologia de informacion (IT), ha revolucionado nuestra era. A partir de ahí comenzó lo que se conoce como la "cuarta revolución industrial", un cambio de época que se está desarrollando con un ancho y una velocidad nunca antes vistos, invirtiendo una pluralidad de campos como nunca antes había ocurrido.

Inteligencia artificial (AI), robótica, biotecnología, nanotecnología, internet de las cosas (IoT), conducción autónoma, computación cuántica son solo algunos de los sectores que atraviesan un período de progreso continuo, extraordinario por la variedad y profundidad de los resultados y por su velocidad de desarrollo.

De acuerdo con el acrónimo de TI, a menudo nos centramos en la tecnología T, que es computadoras: máquinas cada vez más potentes, capaces de duplicar la capacidad computacional cada mes 18, según una ley, llamada Moore1 - que aunque carece de valor científico, todavía está respaldado por más 50 años de observación de la realidad.

Dicho esto, y sin quitarle nada a la importancia que se deriva de las máquinas cada vez más poderosas, la riqueza real de hoy reside en los datos, de hecho, en los GRANDES DATOS derivados de los miles de millones de información producida cada instante por nuestros clics, tweets y preferencias de compra.

En el primer trimestre de 2018, Facebook tuvo 2.19 mil millones de usuarios activos2, que a su vez interactuó con 200 miles de millones de otros individuos en la red: una cifra sobre el 20% de la población del planeta. En el mismo año, YouTube alcanzó los mil quinientos millones de usuarios, seguido de WhatsApp con mil millones y trescientos millones.

Números importantes, que producen una fuente inagotable de datos.

La web, por otro lado, es un entorno en el que millones de personas pasan una parte importante de su vida diaria (en Italia, en promedio 6 horas al día en 2018), intercambiando opiniones, emociones, placeres, tristezas, preferencias de compra. y mucho mas

Un conjunto de comportamientos individuales que pueden ser "fechados", es decir Registrado, analizado y reorganizado. Según criterios científicos que producen continuamente datos.

Dos ejemplos, más que cualquier otro, hacen que la idea de cómo los resultados que buscamos estén ocultos en la información.

En 2006, el portal AoL (Americaonline) ha hecho público, para académicos e investigadores, una base de datos de 20 millones de "consultas" realizadas dentro de los tres meses por miles de usuarios de 675, y lo hizo de forma anónima anónima, por razones de protección. , usuarios involucrados de varias maneras. Sin embargo, después de unos días, Thelma Arnold, una viuda de 60 años de Georgia, se asoció, con razón, con el número de usuario de 4417749, lo que provocó una disputa que llevó al despido de tres empleados de AoL.

E incluso cuando Netflix publicó las preferencias de alrededor de medio millón de usuarios anónimos, no pasó mucho tiempo antes de que una dama del Medio Oeste fuera reconocida por su nombre y dirección. Investigadores de la Universidad de Texas demostraron posteriormente que es posible reconocer a un usuario del canal eligiendo solo películas 6 en 500.

Pero no solo la web es: pensamos en las cámaras, en todas partes, en las calles y plazas de nuestras ciudades, y en las formas y los propósitos con los que dejamos huellas las puede dejar un software especial de reconocimiento facial (hace unos años, un periódico inglés). descubrió que a menos de 200 metros de la casa donde vivía George Orwell, el autor del libro distópico "1984", no había menos que cámaras 30).

De acuerdo con los informes de Viktor Schonberger y Keneth Cukier en su trabajo fundamental.3 (utilizado como fuente principal para este artículo), se produjeron tantos datos en el 2012 que si se cargaran en un CD-ROM se habrían formado cinco pilas paralelas capaces de alcanzar la luna, mientras que si se hubieran impreso en hojas de papel, habrían podido Para cubrir todo el territorio de los Estados Unidos tres veces.

Tenga en cuenta que estamos hablando de 6 hace años, y que mientras tanto los datos producidos cada año se duplicaron dos veces (en promedio, se duplican cada tres años).

Los datos constituyen el oro negro de nuestra era: un valor inestimable, por la cantidad y la multiplicidad de usos, más a menudo diferentes de aquellos para los que se tomaron originalmente. De hecho, cada vez más a menudo, proporcionamos información en línea para fines que, en el momento de su recopilación, aún son desconocidos.

Los datos constituyen el oro negro de nuestra era: un valor inestimable, por la cantidad y la multiplicidad de usos, más a menudo diferentes de aquellos para los que se tomaron originalmente. De hecho, cada vez más a menudo, proporcionamos información en línea para fines que, en el momento de su recopilación, aún son desconocidos.

Alimentan la nueva frontera de la IA, constituyendo el primer combustible: es gracias a ellos que las computadoras progresan y comienzan a "percibir" la realidad externa.

Ellos a través de robots comienzan a realizar acciones autónomas.4, decidido sobre la base de los datos de situación recopilados y analizados en el exterior (y no en la programación recibida).

Pero, ¿cómo se utilizan los DATOS GRANDES? Aplicación de métodos matemáticos, "algoritmos", elaborados sobre la base de lo que desea descubrir en un momento dado, de un fenómeno particular.

Los algoritmos, que explotan grandes cantidades de datos, nos permiten ver cualquier "correlación", entendida como la probabilidad de que una relación dada entre los elementos examinados pueda repetirse.

Lo que entonces tales vínculos surgen por pura coincidencia, nada resta valor a la validez del estudio en sí mismo, porque la inexactitud y la inexactitud son estadísticamente "ajustado" En proporción al número de datos disponibles.

Con el debido respeto al principio de causalidad, que fue bueno en la era de los PEQUEÑOS DATOS cuando el entendimiento se basó en un análisis cuidadoso de los elementos (limitados) disponibles, realizado por personas "expertas" en el sector particular en estudio.

En la era de BIG DATA, la comprensión de los fenómenos se logra en cambio con la ayuda de "data scientist" (científico de datos), un término medio entre un programador, un matemático y un estadístico, y no los expertos tradicionales.

De hecho, en grandes cantidades de datos, la verdad es que no es casual que los algoritmos que ofrecen resultados (probabilísticos) no sean satisfactorios con cantidades limitadas de datos, lo que hace maravillas cuando se aplica a números más grandes.

"Google Translator" proporciona un claro ejemplo de cómo se puede aplicar el criterio probabilístico combinado con la cantidad de información para resolver un problema complejo como la traducción.

El programa, de hecho, no se traduce aplicando las reglas gramaticales ni utilizando los diccionarios almacenados, sino que se basa en la probabilidad de que el contenido de un documento determinado se pueda traducir de acuerdo con las estructuras gramaticales y los significados de las palabras, verbos y adjetivos presentes en los miles de millones de documentos. Todos los idiomas, que tiene en su memoria.

De esta manera, el programa ganó la competencia con Microsoft y se convirtió rápidamente en el traductor más usado del mundo.

En este contexto, como ya se mencionó, la capacidad de cómputo representa solo una parte del proceso, ni siquiera la más importante, como los algoritmos que se usan de vez en cuando. El factor determinante sigue siendo la cantidad de datos disponibles: cuanto más tengamos, mayores serán las posibilidades de encontrar lo que buscamos.

Los GRANDES DATOS "dan alas" a la cuarta revolución industrial, y permiten una mayor comprensión del mundo. Aprender a gestionarlos y utilizarlos al máximo es el desafío que nos espera.

3BIG DATA de Viktor Schonberger y Keneth Cukier - Garzanti 2013

4Un sistema se llama "automatizado" cuando actúa principalmente de una manera determinista, reaccionando siempre de la misma manera cuando se lo somete a las mismas entradas. Un sistema "autónomo", por otro lado, razona sobre una base probabilística: al haber recibido una serie de aportes, elabora las mejores respuestas. A diferencia de lo que sucede con los sistemas automatizados, un sistema autónomo, con la misma entrada, puede producir respuestas diferentes.

Foto: Emilio Labrador / NASA